Kaum eine Technologie verändert Wirtschaft und Gesellschaft derzeit so rasant wie Künstliche Intelligenz. Doch mit steigenden Fähigkeiten wächst auch die Verantwortung, diese Systeme sicher, nachvollziehbar und rechtskonform einzusetzen. Genau hier setzt Microsofts Responsible AI Transparency Report 2025 an – ein Bericht, der tiefe Einblicke in Governance, Risikomanagement und praxisnahe Anwendungsbeispiele gibt. Für uns bei T4M ist er ein wertvoller Gradmesser, wie Unternehmen KI verantwortungsvoll und zugleich innovativ nutzen können.

Governance als Fundament – vom EU AI Act bis zum Frontier Framework

Microsoft zeigt im Report eindrucksvoll, wie konsequente Governance funktioniert. Seit Jahren arbeitet das Unternehmen mit einem klaren Policy-to-Implementation-Prozess, der neue regulatorische Anforderungen – etwa den EU AI Act – frühzeitig integriert. Besonders spannend ist das Frontier Governance Framework, mit dem Risiken hochentwickelter Modelle überwacht und entschärft werden sollen, bevor sie in kritischen Bereichen Schaden anrichten können.

➡️ Wichtig zu wissen: Für deutsche Unternehmen ist das ein wichtiges Signal: Wer heute KI einsetzt, muss Governance nicht nur als Compliance-Übung sehen, sondern als Wettbewerbsvorteil. Denn nur wer Vertrauen schafft, kann KI nachhaltig skalieren.

Risikomanagement in der Praxis – Mapping, Messen, Managen

Der Bericht macht deutlich, dass Risikomanagement bei KI ein fortlaufender Prozess ist. Microsoft arbeitet mit mehrstufigen Verfahren:

- Mapping: Identifikation von Risiken durch Red Teaming – 2024 fanden 67 solcher Tests statt, u.a. bei multimodalen Modellen.

- Measure: Automatisierte Messpipelines, die unerwünschte Inhalte erkennen – inzwischen auch für Audio, Video und Code.

- Manage: „Defense in Depth“-Ansatz, etwa mit Prompt Shields gegen Jailbreaks und Groundedness Detection, die falsche Antworten in Echtzeit korrigieren kann.

➡️ Wichtig zu wissen: Diese Tools sind nicht nur für Tech-Giganten relevant. Auch Mittelständler profitieren, wenn sie KI-Anwendungen mit ähnlichen Prüf- und Monitoring-Mechanismen ausstatten – sei es im Kundenservice oder in der Produktion.

Praxisbeispiele – von Sprach-Copilot bis Radiologie

Besonders eindrucksvoll sind die Fallstudien:

- Phi-Modelle: Microsoft entwickelt Small Language Models nach einem „Break-Fix“-Zyklus – jede Schwachstelle fließt direkt in den nächsten Trainingsdurchlauf. Ergebnis: Bis zu 75 % weniger unerwünschte Inhalte.

- Copilot Voice: Mit GPT-4o integrierte Microsoft Audio-Interaktionen in Copilot – nach umfangreichen Red Teamings, um Risiken wie Stimm-Imitationen zu kontrollieren.

- Smart Impression: In der Radiologie beispielsweise unterstützt KI Ärzte bei Befundberichten. Dabei gilt: KI erstellt nur Entwürfe, die immer durch den Radiologen geprüft werden müssen.

➡️ Wichtig zu wissen: Diese Beispiele zeigen, dass „Human-in-the-Loop“ mehr als ein Buzzword ist. Ob in Medizin, Industrie oder Verwaltung – KI bleibt nur dann vertrauenswürdig, wenn Menschen die letzte Instanz sind.

Unterstützung für Kunden – Verantwortung als Service

Microsoft setzt nicht nur intern auf Governance, sondern bietet auch Kunden Hilfestellung:

- AI Customer Commitments: Schutz vor Copyright-Klagen bei KI-Ausgaben.

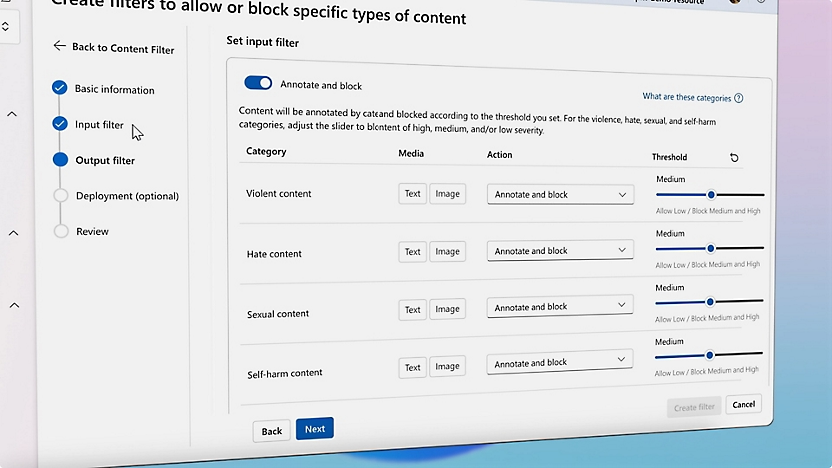

- Azure AI Content Safety: Schutz vor schädlichen Inhalten – inzwischen multimodal und sogar on-device verfügbar.

- Transparenz-Initiativen: Von Content Credentials bei LinkedIn bis zu detaillierten Web-Query-Logs in Copilot.

- AI Literacy: Schulungsangebote, von Einsteigerkursen bis zu Tools wie dem AI Skills Navigator.

➡️ Wichtig zu wissen: Genau das brauchen deutsche Unternehmen: praktische Werkzeuge, Dokumentation und Trainings, um nicht nur rechtskonform, sondern auch souverän mit KI zu arbeiten.

Forschung, Standards & Ausblick

Mit Initiativen wie dem AILuminate-Benchmark oder dem AI & Society Fellows Program zeigt Microsoft, dass Forschung, Politik und Praxis zusammengehören. 2025 liegt der Fokus laut Report auf drei Prioritäten:

- Agilere Risikomanagement-Tools entwickeln.

- Governance entlang der gesamten KI-Supply-Chain etablieren.

- Gemeinsame Standards und Metriken für KI-Risiken schaffen.

➡️ Wichtig zu wissen: Für uns ist klar: Wer KI erfolgreich einsetzen will, muss Governance, Technik und Menschen zusammendenken. Wir sehen darin keine Bremse, sondern eine Chance, Innovation verantwortungsvoll und skalierbar zu gestalten.

Fazit: Verantwortung ist der Schlüssel zur Innovation

Der Responsible AI Transparency Report 2025 zeigt: Verantwortung und Innovation sind keine Gegensätze – sie bedingen einander. Für Unternehmen in Deutschland bedeutet das: Wer frühzeitig auf Governance, Risikomanagement und Transparenz setzt, verschafft sich nicht nur regulatorische Sicherheit, sondern auch einen klaren Vertrauensvorsprung bei Kunden, Partnern und Mitarbeitenden.

Bei T4M begleiten wir diesen Weg aktiv – mit Expertise, praxisnahen Lösungen und dem Anspruch, KI so einzusetzen, dass sie Unternehmen stärkt und Menschen wirklich unterstützt.

Views: 2181